من الواضح أن الذكاء الاصطناعي سيكون له تأثير تحويلي هائل على طريقة حياتنا وعملنا ولعبنا

هل هناك مخاطر للذكاء الاصطناعي؟ كما هو الحال مع معظم الأمور المتعلقة بالذكاء الاصطناعي، فإن الإجابة على هذا السؤال لها العديد من الجوانب، هناك بعض المخاطر المرتبطة بالذكاء الاصطناعي، بعضها عملي وبعضها أخلاقي، يناقش كبار الخبراء مدى خطورة الذكاء الاصطناعي في المستقبل، ولكن لا يوجد إجماع حقيقي حتى الآن.

ومع ذلك، هناك بعض المخاطر التي يتفق عليها الخبراء. العديد منها مجرد حالات افتراضية قد تحدث في المستقبل دون اتخاذ الاحتياطات المناسبة، وبعضها مخاوف حقيقية نتعامل معها اليوم.

تشمل المخاطر في الحياة الواقعية أمورًا مثل خصوصية المستهلك والمسائل القانونية وتحيز الذكاء الاصطناعي وغير ذلك. أما المسائل الافتراضية المستقبلية فتشمل أمورًا مثل الذكاء الاصطناعي المبرمج لإلحاق الضرر أو الذكاء الاصطناعي الذي يطور سلوكيات مدمرة.

مخاطر الذكاء الاصطناعي في الحياة الواقعية

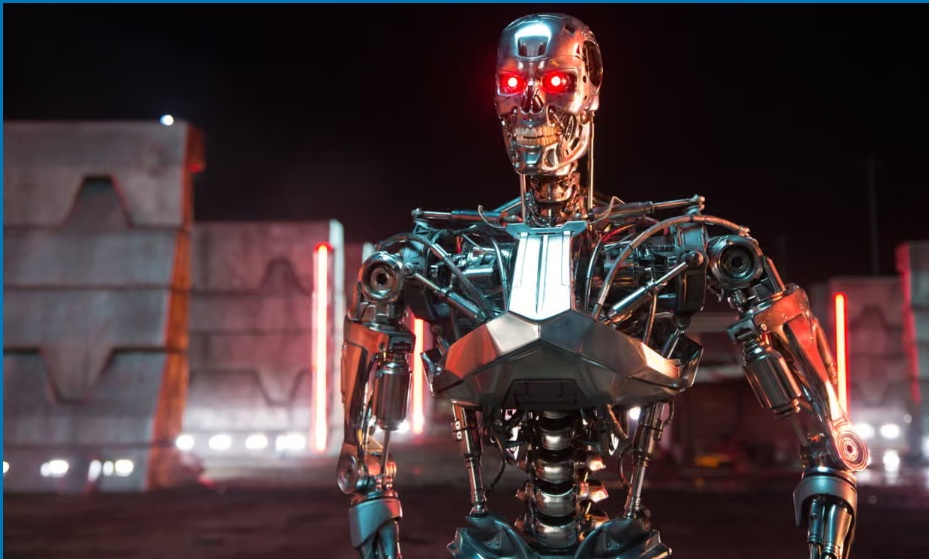

هناك عدد لا يحصى من المخاطر المتعلقة بالذكاء الاصطناعي التي نواجهها في حياتنا اليوم. ليست كل مخاطر الذكاء الاصطناعي كبيرة ومقلقة مثل الروبوتات القاتلة أو الذكاء الاصطناعي الواعي. تشمل بعض أكبر المخاطر اليوم أمورًا مثل:

– خصوصية المستخدم،

– والبرمجة المتحيزة،

– والخطر على البشر،

– واللوائح القانونية غير الواضحة.

1- الخصوصية

أحد أكبر المخاوف التي يذكرها الخبراء يتعلق بخصوصية بيانات المستهلكين وأمنها والذكاء الاصطناعي. للأمريكيين الحق في الخصوصية، الذي تم إقراره في عام 1992 مع التصديق على العهد الدولي الخاص بالحقوق المدنية والسياسية. لكن العديد من الشركات تتجاهل بالفعل انتهاكات خصوصية البيانات من خلال ممارساتها في جمع البيانات واستخدامها، ويخشى الخبراء أن يزداد هذا الأمر مع بدء استخدامنا للذكاء الاصطناعي بشكل أكبر.

ومن المخاوف الرئيسية الأخرى أنه لا توجد حاليًا سوى قوانين قليلة بشأن الذكاء الاصطناعي (بشكل عام أو فيما يتعلق بخصوصية البيانات) على المستوى المحلي أو الدولي. وقد قدم الاتحاد الأوروبي “قانون الذكاء الاصطناعي” في أبريل 2021 لتنظيم أنظمة الذكاء الاصطناعي التي تعتبر خطرة؛ ولكن هذا القانون لم يتم إقراره بعد.

2- تحيز الذكاء الاصطناعي

الضرر الناجم عن تكوين الذكاء الاصطناعي للصور النمطية واضح في العالم الحقيقي، مثل عندما تفشل برامج التعرف على الوجوه في التعرف بدقة على الأشخاص ذوي البشرة الملونة أو عندما يفرق الذكاء الاصطناعي بين الرجل والمرأة

من المعتقدات الشائعة أن الذكاء الاصطناعي، باعتباره نظامًا إلكترونياً، هو بطبيعته غير متحيز. لكن هذا غير صحيح على الإطلاق. فالذكاء الاصطناعي لا يكون غير متحيز إلا بقدر عدم تحيز البيانات والأشخاص الذين يدربون البرامج. لذا، إذا كانت البيانات معيبة أو غير محايدة أو متحيزة بأي شكل من الأشكال، فإن الذكاء الاصطناعي الناتج سيكون متحيزًا أيضًا. النوعان الرئيسيان من التحيز في الذكاء الاصطناعي هما “تحيز البيانات” و”تحيز المجتمع”.

يحدث تحيز البيانات عندما تكون البيانات المستخدمة لتطوير وتدريب الذكاء الاصطناعي غير كاملة أو منحرفة أو غير صالحة. وقد يرجع ذلك إلى أن البيانات غير صحيحة أو تستبعد مجموعات معينة أو تم جمعها بسوء نية.

من ناحية أخرى، يحدث التحيز المجتمعي عندما تتسرب الافتراضات والتحيزات الموجودة في المجتمع اليومي إلى الذكاء الاصطناعي من خلال النقاط العمياء والتوقعات التي كان يحملها المبرمجون عند إنشاء الذكاء الاصطناعي.

3- تفاعل الذكاء الاصطناعي مع البشر

في الماضي، عندما كان الذكاء الاصطناعي يكتفي بإصدار التنبؤات والروبوتات تتنقل في غرف مليئة بالكراسي، كان السؤال حول كيفية تفاعل البشر والذكاء الاصطناعي سؤالاً وجودياً أكثر منه مصدر قلق. ولكن الآن، مع تغلغل الذكاء الاصطناعي في الحياة اليومية، أصبح السؤال أكثر إلحاحاً. كيف يؤثر التفاعل مع الذكاء الاصطناعي على البشر؟

صورة لسيارة ذاتية القيادة في حادث بمدينة نيويورك الأمريكية

هناك مخاوف تتعلق بالسلامة الجسدية. في عام 2018، اصطدمت سيارة ذاتية القيادة تستخدمها شركة أوبر لتشارك الرحلات بأحد المشاة وأودت بحياته في حادث سير. في تلك الحالة بالذات، قضت المحكمة بأن السائقة الاحتياطية للسيارة ذاتية القيادة كانت مخطئة، لأنها كانت تشاهد برنامجًا على هاتفها بدلاً من الانتباه إلى محيطها.

بالإضافة إلى هذا السيناريو، هناك سيناريوهات أخرى يمكن أن تسبب أضرارًا جسدية للبشر. إذا اعتمدت الشركات بشكل مفرط على تنبؤات الذكاء الاصطناعي بشأن موعد إجراء الصيانة دون إجراء فحوصات أخرى، فقد يؤدي ذلك إلى أعطال في الآلات تؤدي إلى إصابة العمال. قد تتسبب النماذج المستخدمة في الرعاية الصحية في تشخيصات خاطئة.

وهناك طرق أخرى غير جسدية يمكن أن يضر بها الذكاء الاصطناعي بالبشر إذا لم يتم تنظيمه بعناية. يمكن أن يتسبب الذكاء الاصطناعي في مشاكل تتعلق بالسلامة الرقمية (مثل التشهير أو القذف)، أو السلامة المالية (مثل إساءة استخدام الذكاء الاصطناعي في التوصيات المالية أو التحقق من الائتمان، أو العكس، مثل المخططات المعقدة التي تسرق أو تستغل المعلومات المالية)، أو الإنصاف (التحيزات المضمنة في الذكاء الاصطناعي التي يمكن أن تتسبب في رفض أو قبول غير عادل في العديد من البرامج).

4- المسؤولية القانونية

وأخيرًا، مسألة المسؤولية القانونية، التي تتعلق بجميع المخاطر الأخرى التي تمت مناقشتها أعلاه تقريبًا. عندما يحدث خطأ ما، من المسؤول؟

– الذكاء الاصطناعي نفسه؟

– المبرمج الذي طوره؟

– الشركة التي نفذته؟

– أو، إذا كان هناك إنسان متورط، فهل الخطأ يقع على عاتق المشغل البشري؟

تحدثنا أعلاه عن سيارة ذاتية القيادة قتلت أحد المشاة، حيث تم إثبات خطأ السائق الاحتياطي. ولكن هل يشكل ذلك سابقة لكل الحالات التي تتعلق بالذكاء الاصطناعي؟ ربما لا، لأن المسألة معقدة ومتغيرة باستمرار. ستكون للاستخدامات المختلفة للذكاء الاصطناعي مسؤوليات قانونية مختلفة إذا حدث خطأ ما.

المخاطر الافتراضية للذكاء الاصطناعي

الآن بعد أن تناولنا المخاطر اليومية للذكاء الاصطناعي، سنتحدث قليلاً عن بعض المخاطر الافتراضية. قد لا تكون هذه المخاطر شديدة كما تراها في أفلام الخيال العلمي، ولكنها لا تزال تشكل مصدر قلق، ويقوم كبار خبراء الذكاء الاصطناعي حالياً بالعمل على منعها وتنظيمها.

1- الذكاء الاصطناعي المبرمج لإلحاق الضرر

هناك خطر آخر يذكره الخبراء عند الحديث عن مخاطر الذكاء الاصطناعي، وهو احتمال أن يتم برمجة شيء يستخدم الذكاء الاصطناعي للقيام بأعمال مدمرة. وأفضل مثال على ذلك هو فكرة “الأسلحة المستقلة” التي يمكن برمجتها لقتل البشر في الحرب.

وقد حظرت العديد من الدول بالفعل الأسلحة المستقلة في الحرب، ولكن هناك طرق أخرى يمكن من خلالها برمجة الذكاء الاصطناعي لإلحاق الأذى بالبشر. ويخشى الخبراء من أن يتطور الذكاء الاصطناعي بحيث يمكن استخدامه لأغراض شريرة وإلحاق الأذى بالبشرية.

2- الذكاء الاصطناعي يطور سلوكيات مدمرة

هناك مخاوف أخرى، مرتبطة إلى حد ما بالمخاوف السابقة، وهي أن الذكاء الاصطناعي سيُعطى هدفًا مفيدًا، ولكنه سيطور سلوكيات مدمرة في محاولته لتحقيق هذا الهدف. ومن الأمثلة على ذلك نظام الذكاء الاصطناعي المكلف بمهمة مفيدة، مثل المساعدة في إعادة بناء النظام البيئي لكائن بحري مهدد بالانقراض.

ولكن في أثناء قيامه بذلك، قد يقرر أن أجزاء أخرى من النظام البيئي غير مهمة ويقوم بتدميرها. وقد ينظر أيضًا إلى تدخل البشر لإصلاح أو منع ذلك على أنه تهديد لهدفه.

إن التأكد من أن الذكاء الاصطناعي يتوافق تمامًا مع أهداف البشر أمر صعب للغاية ويتطلب برمجة دقيقة. الذكاء الاصطناعي ذو الأهداف الغامضة والطموحة مثير للقلق، لأننا لا نعرف المسار الذي قد يقرر اتباعه لتحقيق هدفه المحدد.

لماذا البحث في سلامة الذكاء الاصطناعي؟

قبل بضع سنوات، كانت فكرة الذكاء الاصطناعي الخارق تبدو خيالية. ولكن مع التطورات الأخيرة في مجال الذكاء الاصطناعي، يعتقد الباحثون الآن أن ذلك قد يحدث في غضون العقود القليلة المقبلة، على الرغم من أنهم لا يعرفون بالضبط متى.

مع هذه التطورات السريعة، أصبح من المهم أكثر أن يتم البحث في سلامة الذكاء الاصطناعي وتنظيمه ومناقشته على المستويين الوطني والدولي.

أكثر من 1000 خبير رائد في مجال الذكاء الاصطناعي وقعوا على رسالة مفتوحة تدعو إلى حظر تطوير الذكاء الاصطناعي العسكري والأسلحة التي تعمل بدون تدخل بشري

في عام 2015، وقع العديد من خبراء التكنولوجيا البارزين (بمن فيهم ستيفن هوكينج وإيلون ماسك وستيف وزنياك) على رسالة مفتوحة حول الذكاء الاصطناعي دعت إلى إجراء أبحاث حول الآثار الاجتماعية للذكاء الاصطناعي.

وتغطي بعض المخاوف التي أثيرت في الرسالة أمورًا مثل أخلاقيات استخدام الأسلحة المستقلة في الحرب، والمخاوف المتعلقة بسلامة المركبات ذاتية القيادة. على المدى الطويل، تفترض الرسالة أنه ما لم يتم توخي الحذر، يمكن للبشر أن يفقدوا بسهولة السيطرة على الذكاء الاصطناعي وأهدافه وأساليبه.

تكمن أهمية سلامة الذكاء الاصطناعي في الحفاظ على سلامة البشر وضمان وجود لوائح تنظيمية مناسبة لضمان عمل الذكاء الاصطناعي كما ينبغي. قد لا تبدو هذه القضايا ملحة، ولكن معالجتها الآن يمكن أن تمنع حدوث نتائج أسوأ بكثير في المستقبل.

هل فوائد الذكاء الاصطناعي تفوق مخاطره؟

بعد قراءة جميع المخاطر والأخطار المرتبطة بالذكاء الاصطناعي الموضحة في هذه المقالة، قد تسأل نفسك: هل الأمر يستحق العناء؟

حسنًا، تتحدث هذه الرسالة المفتوحة أيضًا عن الفوائد المحتملة التي يمكن أن يجلبها الذكاء الاصطناعي للمجتمع إذا تم استخدامه بشكل صحيح. يذكر مقال مرفق حول أولويات البحث أنه “… لا يمكننا التنبؤ بما يمكن أن نحققه عندما يتم تعزيز هذا الذكاء بواسطة الأدوات التي قد يوفرها الذكاء الاصطناعي، ولكن القضاء على الأمراض والفقر ليس أمرًا مستحيلًا”.

الفوائد المحتملة لمواصلة البحث في مجال الذكاء الاصطناعي كبيرة. الآن، مع قيام وكلاء الذكاء الاصطناعي AI Agents بإدارة سير العمل المعقد وتحليل البيانات واتخاذ القرارات في الوقت الفعلي، بدأنا فقط في فهم مدى قدرة هذه الأدوات على إحداث تحول.

وعلى الرغم من وجود مخاطر يجب أخذها في الاعتبار، فإن المكافأة يمكن اعتبارها تستحق العناء.

المصدر: http://www.tableau.com